Introduction

Le dictionnaire des lunettes IA : comprendre les termes (AR, FoV, waveguide, XR…)

Temps de lecture : ~X min

- Les bases pour bien comprendre

- AR, VR, MR, XR : les grandes familles d’expériences

- FoV, waveguide, micro-OLED : le trio qui explique l’affichage

- HUD, confort visuel et compromis du quotidien

- NPU, IA embarquée et edge computing : le cerveau des lunettes

- IMU, SLAM, eye-tracking : comment les lunettes comprennent l’espace

- Audio, traduction et confidentialité : ce qui change vraiment l’usage

- Critères pratiques pour choisir

Les bases pour bien comprendre

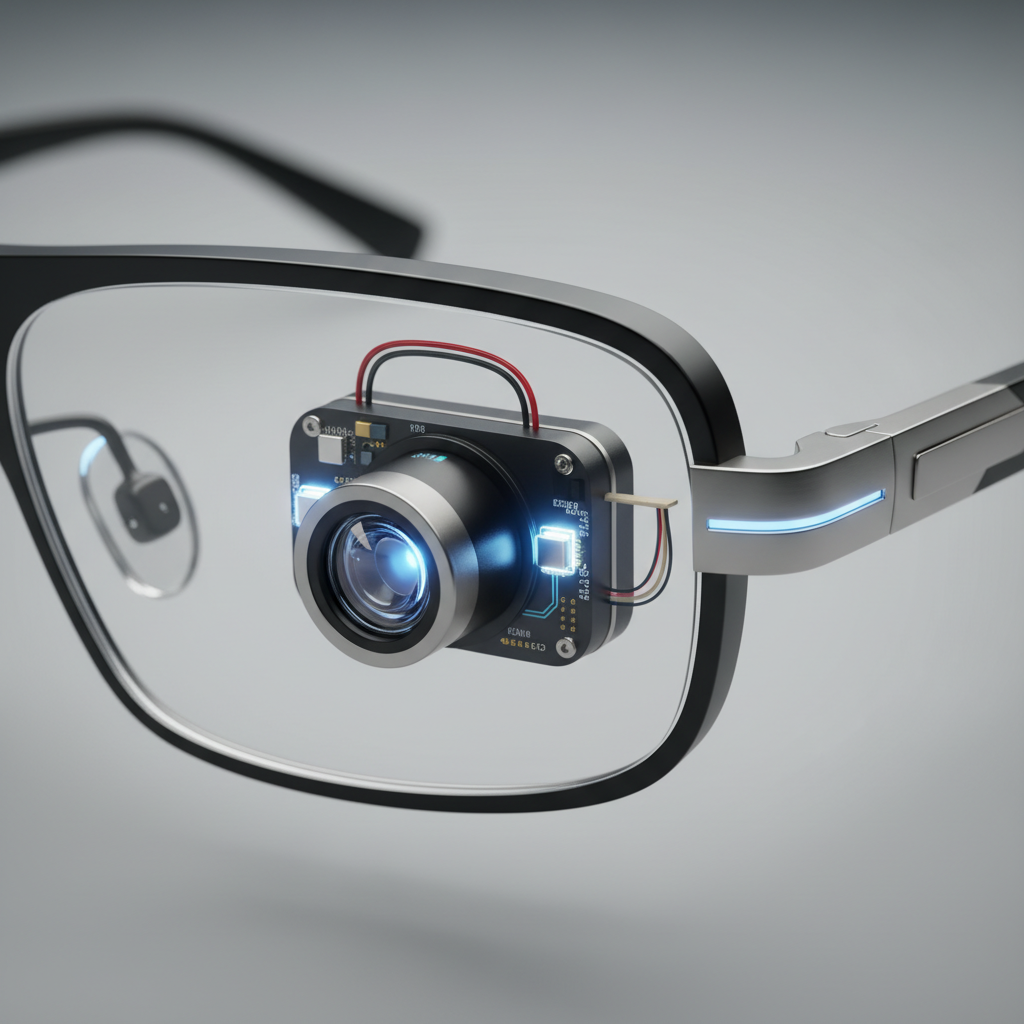

Commençons par définir ce qu’on appelle « lunettes IA ». Il s’agit de lunettes intelligentes qui intègrent, dans la monture, une combinaison de capteurs (caméra, microphones, parfois d’autres capteurs), de connectivité (Bluetooth, parfois Wi-Fi) et de calculs d’intelligence artificielle. Selon les modèles, elles peuvent afficher des informations dans votre champ de vision, ou fonctionner surtout en audio mains libres, un peu comme des écouteurs… mais portés sur le visage. Ce point est important : toutes les lunettes IA ne sont pas des lunettes “à écran”. Certaines misent sur la discrétion et la voix, d’autres ajoutent un affichage de type HUD (head-up display) pour faire apparaître du texte, des pictogrammes ou des indications de navigation directement sur le verre.

La différence se voit aussi dans les usages : traduction en temps réel, assistant vocal enrichi par la vision, reconnaissance d’objets, rappels contextuels, etc. Et plus une paire de lunettes veut faire “beaucoup”, plus elle doit jongler avec des contraintes fortes : poids, autonomie, chauffe, et acceptation sociale. D’où l’intérêt de comprendre les termes clés avant de choisir.

AR, VR, MR, XR : les grandes familles d’expériences

Le premier bloc de jargon tourne autour des “réalités”. La réalité augmentée (AR) est la plus liée aux lunettes IA du moment : elle superpose des informations numériques au monde réel, visible à travers des verres transparents. Concrètement, cela peut être des sous-titres de traduction qui s’affichent pendant une discussion, une notification discrète, ou une flèche de navigation dans un coin du champ de vision.

La réalité virtuelle (VR) plonge dans un monde 100 % numérique et nécessite généralement un casque opaque : ce n’est pas la logique des lunettes du quotidien. La réalité mixte (MR) va plus loin que l’AR simple : les éléments virtuels semblent réellement ancrés dans l’environnement, ce qui demande un suivi spatial très précis et des capteurs/algorithmes plus avancés. Enfin, XR (Extended Reality) est un terme “parapluie” qui regroupe AR, VR et MR. Vous verrez donc souvent l’expression “lunettes XR” pour parler de produits qui combinent affichage, audio et capteurs, même si l’usage principal reste l’AR ou l’assistance audio.

FoV, waveguide, micro-OLED : le trio qui explique l’affichage

Quand une paire de lunettes IA affiche du contenu, trois termes reviennent tout le temps.

FoV (Field of View)

Le champ de vision (FoV) est la “fenêtre” dans laquelle vous voyez l’image générée. Un petit FoV suffit pour afficher du texte discret (traduction, notifications, rappels), tandis qu’un grand FoV donne une impression plus immersive, plus proche d’un casque AR/MR. Mais il y a un compromis : augmenter le FoV complique l’optique, augmente souvent le coût, et peut peser sur l’autonomie.

Waveguide

Le waveguide (guide d’ondes) est la technologie qui permet d’amener la lumière d’un micro-écran jusqu’à votre œil tout en laissant passer la vision du monde réel. Imaginez une lentille transparente qui “canalise” l’image et la redirige vers la pupille grâce à des structures optiques (diffraction, holographie).

Micro-OLED

La source d’image est fréquemment un micro-OLED : un écran minuscule, très dense en pixels, idéal pour afficher un texte net dans un format ultra-compact. D’autres approches existent (micro-LED notamment), mais le couple micro-OLED + waveguide reste central pour des lunettes AR fines.

HUD, confort visuel et compromis du quotidien

Un autre terme utile est HUD (head-up display). Sur une voiture, un HUD projette des informations sur le pare-brise ; sur des lunettes IA, c’est la même philosophie : garder l’info dans votre champ de vision sans vous obliger à baisser la tête vers un écran. Dans la pratique, l’affichage est souvent placé pour rester discret, afin de ne pas perturber la vision.

C’est là que le design devient une question d’équilibre : suffisamment lumineux pour rester lisible, mais pas au point d’être fatigant ; suffisamment présent pour être utile, mais pas au point de capter toute l’attention. À cela s’ajoutent des choix concrets : verres correcteurs possibles (ou adaptateurs), options photochromiques, filtres (anti-lumière bleue). Le tout doit tenir dans une monture confortable et socialement “portable”.

Beaucoup de modèles avancés visent un poids autour de quelques dizaines de grammes, ce qui impose de miniaturiser batterie, haut-parleurs et électronique. Et comme la batterie n’est pas infinie, les fabricants annoncent souvent des autonomies de l’ordre de 6 à 8 heures en usage actif, parfois plus sur des produits optimisés.

NPU, IA embarquée et edge computing : le cerveau des lunettes

L’IA embarquée (on-device AI) signifie que les calculs se font directement dans les lunettes, sans envoyer systématiquement audio et vidéo vers le cloud. C’est un point clé pour la réactivité (moins de latence) et la confidentialité (moins de données qui circulent).

Pour rendre cela possible, certaines lunettes intègrent une NPU (Neural Processing Unit), un processeur spécialisé dans les réseaux de neurones, pratique pour la reconnaissance vocale, l’analyse d’images ou des fonctions d’IA générative “légère”. On parle aussi d’edge computing pour désigner cette logique : calculer au plus près de l’utilisateur, sur l’appareil.

Dans la pratique, beaucoup de produits combinent local et cloud : le local gère le temps réel et ce qui est sensible, tandis que le cloud prend en charge les tâches plus lourdes ou les services connectés. La majorité des lunettes IA s’appuie sur une application compagnon pour les réglages, les mises à jour et parfois des mini-apps via des API ouvertes.

IMU, SLAM, eye-tracking : comment les lunettes comprennent l’espace

Pour stabiliser l’affichage et proposer des interactions naturelles, les lunettes IA exploitent plusieurs capteurs et algorithmes :

- IMU (Inertial Measurement Unit) : combine accéléromètre et gyroscope pour mesurer l’orientation et les mouvements de tête, utile même sans AR avancée.

- SLAM (Simultaneous Localization and Mapping) : se localiser dans un lieu tout en cartographiant l’environnement (surfaces, profondeur, géométrie), indispensable pour “poser” des éléments virtuels de façon réaliste.

- Eye-tracking : détecte où l’utilisateur regarde pour sélectionner des éléments par le regard ou optimiser le rendu (plus de détail là où l’œil se pose).

Audio, traduction et confidentialité : ce qui change vraiment l’usage

L’audio est souvent l’interface la plus naturelle, via des haut-parleurs intégrés ou la conduction osseuse. Cela permet de rester conscient de l’environnement tout en recevant des informations.

La traduction en temps réel illustre bien cet usage : certaines lunettes affichent des sous-titres AR, d’autres restituent la traduction à l’oreille, et certaines combinent les deux. La vision par ordinateur permet aussi de reconnaître des objets, du texte ou des scènes pour assister l’utilisateur (lecture, repérage, aide contextuelle).

La navigation et les notifications prennent une autre dimension lorsqu’elles arrivent dans le champ de vision, au bon moment, sans sortir le téléphone.

Critères pratiques pour choisir

- Type d’expérience : AR avec affichage, audio-only ou mixte

- FoV, lisibilité et technologie (waveguide, micro-OLED, HUD)

- IA locale vs cloud (NPU, edge computing) et capteurs (IMU, SLAM)

- Autonomie, confort et options de verres (correcteurs, photochromiques)

- Confidentialité : indicateurs d’enregistrement, permissions, traitement local

Pour plus de détails et comparatifs, consultez notre guide complet lunettes IA.